إستخراج الميزات من النص. الجزء 1

Text feature extraction

في مجال تعلم الألة لايمكن إستعمال نص بشكله الخام كما هو! بل نحتاج إلى التعامل مع أرقام و لهذا نحن بحاجة إلى طريقة لتحويل النصوص إلى أرقام. هناك ثلاث عمليات أساسية و هي : (Tokenizing) تقطيع النص إلى مقاطع أساسية على حسب الفواصل التي نحددها مثل الفراغات التي بين الكلمات. (Counting ) حساب عدد مرات تكرار المقاطع الأساسية في النص. (normalizing) منح أوزان أو قيم للمقاطع الأساسية أو (Tokens).

مكتبة (Scikit-Learn ) وفرت بعض الخوارزميات الجاهزة للتعامل مع النصوص و إستخراج الميزات منها. سوف نشرح جزءا منها في الجزء 1 و الباقي لاحقا إن شاء الله.

1- Binary Encoding :

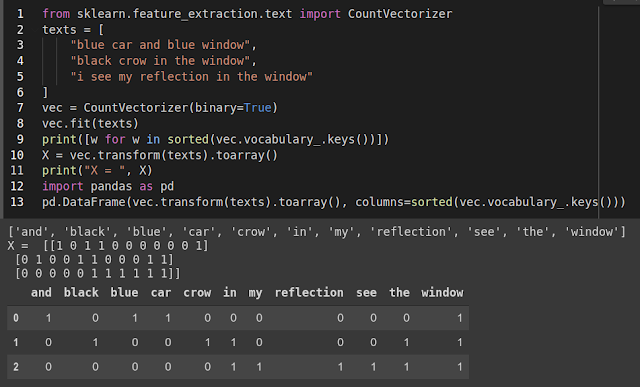

لنفرض أننا إختارنا (Tokens) عبارة عن كلمات. في هذه الطريقة نقوم بتحديد جميع الكلمات التى ظهرت في الداتا على شكل قائمة للمفردات. إذا كان عدد الكلمات (vocabulary list) هو 100 ألف فإن كل نص ينتمى إلى الداتا يتم تمثيله بجدول طوله 100 ألف و كل خانة تقابل كلمة من قائمة المفردات إذا ظهرت هذه الكلمة في النص فإن خانتها تحمل الرقم 1 و إلا 0. الصورة 1 مثال عن هذه الطريقة بإستخدام (CountVectorizer). لدينا ثلاث جمل و لنفترض أنها تمثل النصوص. بعد عملية (fit) في السطر 8 نظهر كل (Tokens ) الموجودة طبعا مكتبة (Scikit-Learn ) تتجاهل الحروف المستقلة و لهذا لم تظهر (I). بعد (transform) نستعرض النتائج في السطر 11 و التي ظهرت في شكل مصفوفة للميزات. مثلا كلمة (blue) ظهرت في الجملة 1 فهي تأخد القيمة 1 في السطر 1 الذي يمثل ميزات الجملة 1. بإستعمال (pandas ) نظهر النتائج في شكل جدول مبسط للتوضيح أكثر.

|

| الصورة 1 |

2- Counting :

هذه العملية تشبه السابقة و لكن لا نكتفي بمعرفة ظهور الكلمة أما لا، بل نقوم بحساب عدد مرات ظهورها و ذلك بتعطيل خاصية (binary = False) و مثال عن ذلك في الصورة 2 بحيث كلمة (blue ) تغيرت قيمتها إلى عدد مرات ظهورها في الجملة 1.

|

| الصورة 2 |

3- TF-IDF:

هذه الطريقة تمنح قيمة أكبر للكلمات المهمة و التي عادة تكون أقل ظهورا في النصوص، بينما حروف التعريف و النكرة و الربط بين الجمل و الظروف تكون أكثر ظهورا دائما. و هذه العملية تتم وفق العلاقة :

tfidf(t, d, D) = tf(t, d) * idf(t, D)

t: is a term (كلمة)

d: is a document (نص)

D: is a collection of all documents (الداتا)

مزيدا من التفاصيل تجدونها على موقع (Scikit-Learn ) و بمعادلات مكتوبة بطريقة سهلة للفهم.

مثال عن هذه الطريقة موجود في الصورة 3 و كما نشاهد هناك قيم مختلفة عن الطريقتين السابقتين.

|

| الصورة 3 |

#الذكاء_الإصطناعي #تعلم_الألة #التعلم_العميق

#artificial_intelligence #machine_learning #deep_learning

الكاتب : هشام فلواط - hichem felouat

In this fashion my friend Wesley Virgin's report launches with this shocking and controversial video.

ReplyDeleteWesley was in the military-and shortly after leaving-he revealed hidden, "self mind control" secrets that the CIA and others used to get whatever they want.

THESE are the EXACT same tactics lots of famous people (especially those who "became famous out of nowhere") and the greatest business people used to become wealthy and successful.

You probably know how you use less than 10% of your brain.

That's because most of your brainpower is UNCONSCIOUS.

Perhaps this thought has even taken place IN YOUR own head... as it did in my good friend Wesley Virgin's head seven years ago, while riding a non-registered, beat-up garbage bucket of a car with a suspended driver's license and on his bank card.

"I'm very fed up with living paycheck to paycheck! Why can't I turn myself successful?"

You've taken part in those types of thoughts, ain't it right?

Your success story is waiting to be written. Go and take a leap of faith in YOURSELF.

UNLOCK YOUR SECRET BRAINPOWER